A Thorough Examination of the CNN/Daily Mail Reading Comprehension Task #PaperWeekly#

本篇是reading comprehension系列的第三篇,文章于2016年6月9号submit在arxiv上,比之前介绍的 Gated-Attention Readers for Text Comprehension 更晚地出现,但尴尬的是本文的模型结果不如GA Reader。6月7号submit的一篇 Iterative Alternating Neural Attention for Machine Reading ,用了和GA非常类似的方法,得到了稍微差一点的结果。确实最近在arxiv上常常可以刷出reading comprehension的paper,可以看得出这个领域当前多么地火热。同时火热的还有dialogue generation任务,今天凌晨的wwdc2016大会中,苹果宣布打造更加智能的siri,几大科技巨头纷纷表示要将聊天机器人作为智能的未来,由此可见与其相关的研究将会越来越热。本文的作者是来自斯坦福大学的博士生 Danqi Chen ,本科毕业于清华的姚班。

虽然本文并没有比GA模型有更好的效果,但作为了解整个Reading Comprehension研究的发展以及模型的思路还是很有意义的。本文最大的贡献在于提出了一种基于人工特征的分类器模型和一个改进版的端到端模型(这里是基于 Teaching Machines to Read and Comprehend 的Attentive Reader模型)。

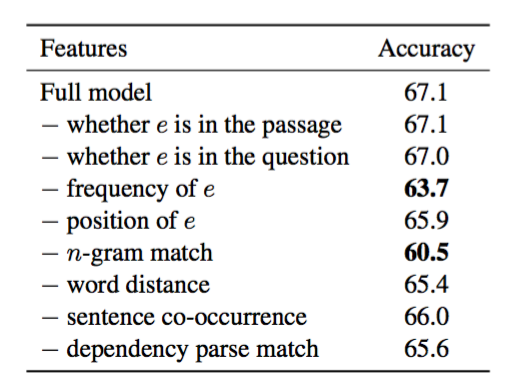

第一个模型,是典型的人工特征模型,通过提取了八个特征构建特征空间,通过使得正确答案entity比其他entity获得更高的得分来训练得到模型参数。包含的特征有:该entity是否出现在原文中,该entity是否出现在问题中,出现过几次,第一次出现的位置等等八个特征。

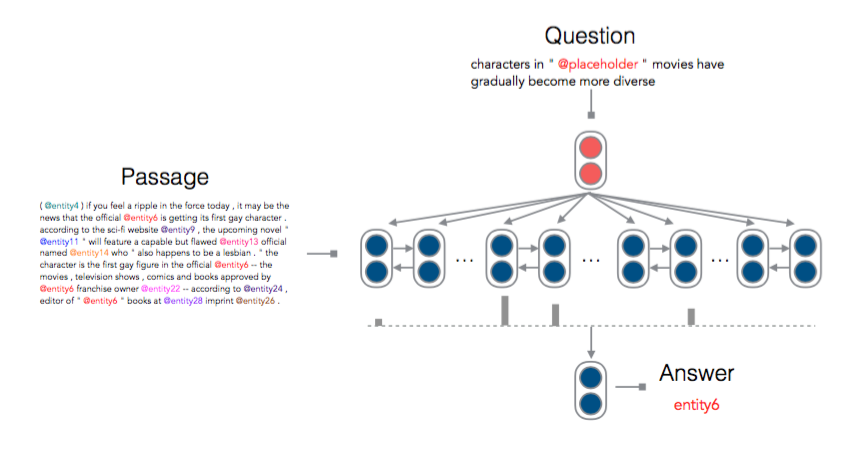

第二个模型,基本思路与Attentive Reader接近。看下图:

这里只介绍不同的地方:

1、在计算query和document的注意力权重时,没有采用非线性的tanh,而是采用了bilinear。

2、得到注意力权重之后,计算context的输出,然后直接用输出进行分类预测,而Attentive Reader是用输出与query又做了一次非线性处理之后才预测的。

3、词汇表中只包括entity,而不是所有的单词。

模型上的改进只有第一点算是吧,后两点只是做了一些简单的优化。

虽然模型简单了,但效果却比Attentive Reader好很多,提升了约5%的效果,我们不管其模型有没有什么亮点,这些简化处理反而得到非常好的效果,这一点很引人深思。

结果这部分,作者分析了八个特征分别对模型结果的影响,其中影响最大的是n-gram match(entity和placeholder是否有相似的上下文),其次是entity出现的频率,具体见下表:

端到端模型比Attentive Reader效果好很多,但和最近的GA来比还是差了很多。看过本文之后,只有一个疑问,简化后的模型为什么比稍微复杂一点的模型好那么多呢?

最后作者总结了下Reading Comprehension任务中常用的数据集:

1、CNN/Daily Mail

2、MCTest

3、Children Book Test(CBT)

4、bAbI

本周末计划将本周看过的几篇reading comprehension写成一篇综述,好好做一次系统地对比和总结。敬请期待。

工具推荐

RSarXiv 一个好用的arxiv cs paper推荐系统 网站地址 ios App下载:App Store 搜索rsarxiv即可获得

PaperWeekly,每周会分享N篇nlp领域好玩的paper,旨在用最少的话说明白paper的贡献。

![[HBLOG]公众号](http://www.liuhaihua.cn/img/qrcode_gzh.jpg)