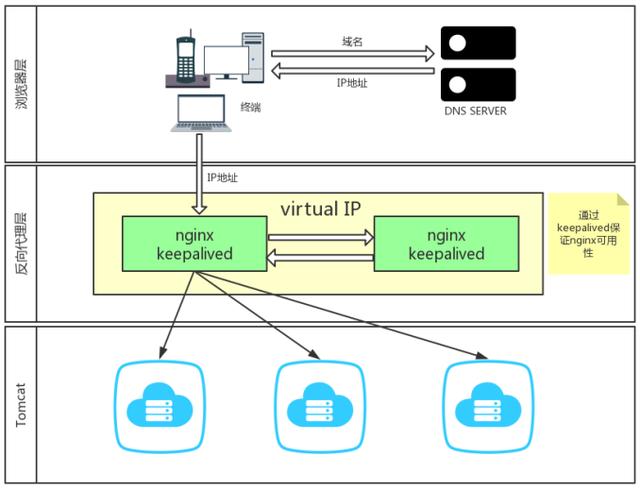

高可用 负载均衡 集群部署方案:Keepalived + Nginx + Tomcat

初期应用较小,一般以单机部署为主,即可满足业务的需求,随着业务的不断扩大,单机部署的模式无法承载这么大的业务量,需要进行服务集群化的部署,本文主要介绍服务器Tomcat多实例部署,搭载Keepalived + Nginx,实现Web服务的高可用。

- Nginx 是一个高性能的 HTTP反向代理服务器

- Keepalived 是一个基于VRRP协议来实现的服务高可用方案,可以利用其来避免服务的单点故障

Nginx作为反向代理服务器,来提供负载均衡的能力,使我们的Web服务器,能够水平扩容,这时反向代理服务器(Nginx)又变成了一个单点,如果挂掉,整合Web服务器就不能被外界访问到;所以需要结合Keepalived来保障反向代理服务器(Nginx)的高可用;

环境准备

- CentOS7系统

- Keepalived-2.0.15

- Nginx-1.14.2

- Tomcat8

准备2台服务器,每台上部署安装Nginx+Keepalived和Tomcat,另外一个VIP(虚拟IP);这里省略了2台,这样在实际模拟中方便演练(Tomcat不单独部署在一台服务器而已)

1、Nginx的安装

2、Keepalived的安装

3、配置Keepalived + Nginx,实现高可用

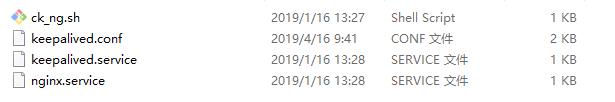

准备的2台服务器上,一台作为MASTER,一台作为BACKUP;每台上需要准备文件如下图

执行如下的约定,上面安装脚本也是按照这个执行的

1. keepalived 和 nginx 都编译安装到/usr/local目录下面,名称分别是keepalived 和 nginx

2. ck_ng.sh、 keepalived.conf 文件放置到/etc/keepalived/目录, ck_ng.sh文件权限设置成755

3. nginx.service、 keepalived.service 文件放置到/usr/lib/systemd/system目录

3.1、MASTER配置

keepalived.conf配置

global_defs {

#notification_email {

# localhost@163.com

#}

#notification_email_from Keepalived@localhost

#smtp_server 163@smtp.com

#smtp_connect_timeout 30

router_id 192.168.1.101 #MASTER服务器的IP地址

}

#配置vrrp_script,主要用于健康检查,以及检查失败后执行的动作。

vrrp_script chk_nginx {

#健康检查脚本,当脚本返回值不为0时认为失败

script "/etc/keepalived/ck_ng.sh"

#检查频率,以下配置每2秒检查1次

interval 2

#当检查失败后,将vrrp_instance的priority减小5

weight -5

#连续监测失败3次,才认为真的健康检查失败。并调整优先级

fall 3

#连续监测2次成功,就认为成功。但不调整优先级

rise 2

}

#定义对外提供服务的VIP vrrp_instance配置

vrrp_instance VI_1 {

#指定vrrp_instance的初始状态,是MASTER还是BackUP主要还是看优先级。

state MASTER

#指定vrrp_instance绑定的网卡,最终会通过指定的网卡宣告VIP

interface ifcfg-eth0

#发送心跳包的源IP,可使用绑定的网卡IP,也可以使用本服务器上的其他IP

mcast_src_ip 192.168.1.101

#相当于VRID,用于在一个网内区分组播,需要组播域内内唯一。

virtual_router_id 55

#本机的优先级,VRID相同的机器中,优先级最高的会被选举为MASTER

priority 100

#心跳间隔,下面配置,MASTER会每隔1秒发送一个报文高职组内其他机器,自己还活着。

advert_int 1

#定义主从的验证方式以及密码,一般使用PASS(最长8位,超过了只会识别前8位作为密码)

authentication {

auth_type PASS

auth_pass 123456

}

#VIP 虚拟 IP 池, 两个节点设置必须一样

virtual_ipaddress {

192.168.1.100/24

}

#本vrrp_instance所引用的脚本配置,名称就是vrrp_script 定义的容器名

track_script {

chk_nginx

}

#状态切换,使用上述配置发送邮件通知

smtp_alert

}

ck_ng.sh配置

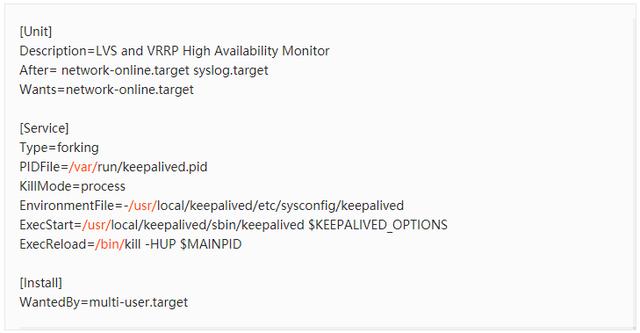

keepalived.service配置

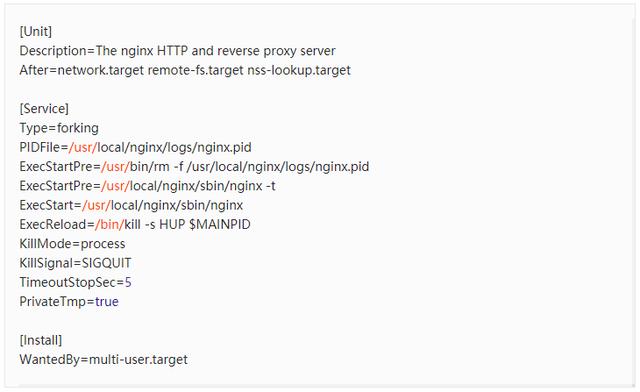

nginx.service配置

3.2、BACKUP配置

keepalived.conf配置(和MASTER类似,列出差异的地方)

global_defs {

router_id 192.168.1.102

}

#定义对外提供服务的VIP vrrp_instance配置

vrrp_instance VI_1 {

#指定vrrp_instance的初始状态,是MASTER还是BackUP主要还是看优先级。

state BACKUP

#发送心跳包的源IP,可使用绑定的网卡IP,也可以使用本服务器上的其他IP

mcast_src_ip 192.168.1.102

#本机的优先级,VRID相同的机器中,优先级最高的会被选举为MASTER

priority 99

}

ck_ng.sh配置(和MASTER一致)

keepalived.service配置(和MASTER一致)

nginx.service配置(和MASTER一致)

3.3、Tomcat服务通过反向代理Nginx对外提供服务

Tomcat的安装和应用部署不再具体描述,主要看一下如何通过Nginx的配置实现对外服务(两个Nginx都通过这样的配置来完成)

nginx.conf配置

# upstream configure

upstream myapp {

ip_hash;

server 192.168.1.101:8080; #Tomcat的应用

server 192.168.1.102:8080; #Tomcat的应用

}

server

{

listen 8888; #假设对外提供的服务端口

server_name localhost;

port_in_redirect on;

location /app1 #Tomcat下的一个应用

{

proxy_pass http://myapp/app1;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_set_header Host $host:$server_port;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

location /app2 #Tomcat下的另外一个应用

{

proxy_pass http://myapp/app2;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_set_header Host $host:$server_port;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

location /

{

proxy_pass http://myapp;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_set_header Host $host:$server_port;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

通过以上的搭建,可以实现高可用、负载均衡 集群部署方案。

![[HBLOG]公众号](http://www.liuhaihua.cn/img/qrcode_gzh.jpg)