百万数据的对账优化

写在前面

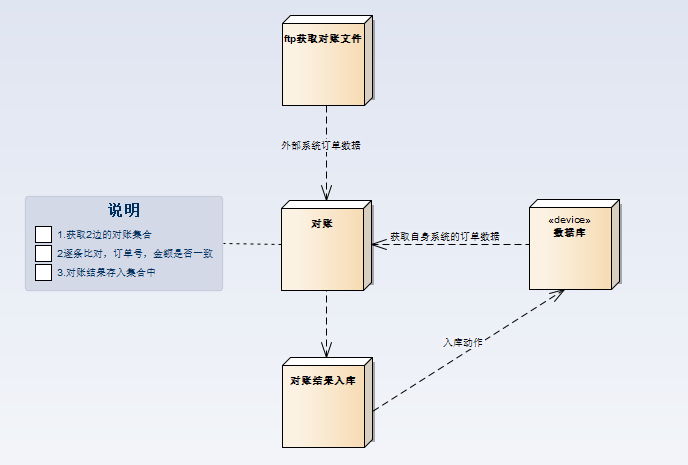

最近线上的对账程序一直不稳定,经常出现对账时间超长,影响结算跑批任务,导致后续业务受影响。原来的流程

系统订单量不大的情况下可以这样子处理没有什么异常问题,随着系统订单的增长,对账时间不断增长,远远超过我们能忍的极限,比如说:到早上还没有对帐完,影响第二天出结算单的时间,不能做到财务T+1结算。极大的阻碍了业务的正常发展。

系统订单量不大的情况下可以这样子处理没有什么异常问题,随着系统订单的增长,对账时间不断增长,远远超过我们能忍的极限,比如说:到早上还没有对帐完,影响第二天出结算单的时间,不能做到财务T+1结算。极大的阻碍了业务的正常发展。

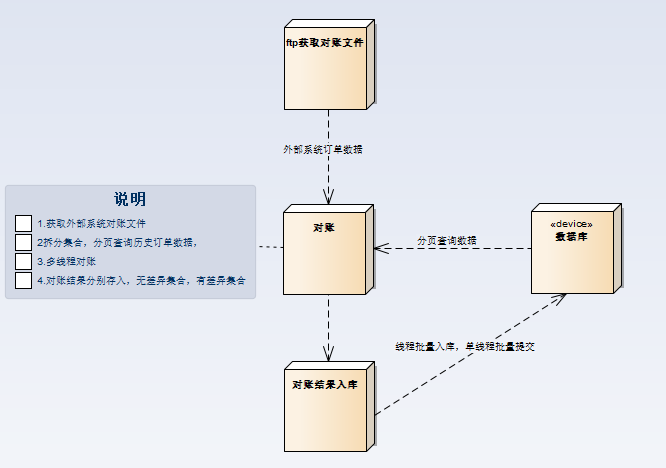

优化后的流程

优化思路大概分为以下几步:- 将系统之前的串行对账改成并行对账

- 查询订单数据改成分布查询,不能一次加载几百万数据

- 对账结果分多线程批量写入

需要注意的地方:

需要注意的地方:

- 线程之间通信的问题,可以采用共享变量方式将对账结果存入ConcurrentHashMap

- 线程数的大小需要控制好,不能超出机器本身的负载能力,

- 每次对完账之后记得清除集合数据,防止内存溢出

正文到此结束

- 本文标签: 对账

- 版权声明: 本文由HARRIES原创发布,转载请遵循《署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)》许可协议授权

- 本文海报: 生成海报一 生成海报二

热门推荐

相关文章

Loading...

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)