AAAI-16: 源远流长,博大包容

本文作者:微软亚洲研究院实习生 孙诗昭

AAAI 是人工智能领域的顶级会议,每年举办一次,今年已是第 30 届,可谓源远流长。这届的 AAAI ( AAAI-16 )共收到 2132 篇投稿,最终录取 549 篇,其中包括了自然语言处理,机器学习,信息检索,机器人,以及博弈论等多个领域的文章,涵盖了人工智能领域的方方面面。 AAAI-16 的举办地在美国亚利桑那州的菲尼克斯,这是一个干旱炎热的热带沙漠城市。虽然会议在 2 月份举办,当北半球绝大多数地方正处于寒冷的冬季,菲尼克斯的气温仍在 30 摄氏度以上。此次会议为期 6 天,前两天是主题讲座( tutorial ),后四天是特邀报告( invited talk )及技术研讨会( technical session )。

AAAI-16的举办场所Phoenix Convention Center

AAAI-16的举办场所Phoenix Convention Center

AAAI-16参会人员正在排队注册

AAAI-16参会人员正在排队注册

丰富多样的主题讲座和特邀报告

AAAI-16 共举办了 16 场主题讲座,每场持续 4 个小时。这些主题讲座严谨考究地梳理了某些特定研究领域的发展历史和前沿成果。今年的主题讲座中,有对人类与人工智能的探讨,如 Organ Exchanges — A Success Story of AI in Healthcare , AI for Disasters 等;有为人工智能新人准备的入门讲座,如 Deep Learning: from Foundations to Implementation , How to Automatically Machine Read the Web 等;有人工智能领域的方法及理论的探讨,如 Symbolic Methods for Hybrid Inference,Optimization, and Decision-making , Answer Set Programming ModuloTheories 等。其中, Deep Learning: from Foundations to Implementation 是最为火爆的一场主题讲座,不仅座无虚席,甚至在过道中都站满了人。这场讲座从线性分类器讲起,指出了在特定的特征下,所有的分类的问题都可以用线性分类器解决。因此,问题便转换成为如何提取好的特征。在机器学习发展的历程中,人为的手动挑特征和利用核函数生成特征都是比较常用的方法。然而,人为的手动挑特征效率极低,不适合在高维特征和复杂问题时使用;核函数的设计不仅十分困难,并且依赖于具体问题。神经网络提供了一种从数据中学习恰当特征的方法,它有效地避免了人为的手动挑特征和核函数的弊端。

此外, AAAI-16 还举办了多场特邀报告。特邀报告的主讲人既有来自高校的著名教授,也有来自企业界的项目负责人。比起主题讲座,特邀报告更加宏观,更加偏重对人工智能领域发展的展望和预测。例如, AAAI 主席 Tom G. Dietterich 教授阐述了人们对于稳健 AI 的需求,提出了通往稳健 AI 的 8 种途径; Toby Walsh 教授组织了关于人工智能与劳动力市场的讨论,分析了人类如何面对越来越多的工作不断的被自动化的机器所取代的趋势等等。

特邀报告准备中

特邀报告准备中

座无虚席的特邀报告现场

座无虚席的特邀报告现场

别出心裁的学生活动

在多场主题讲座,特邀报告和技术研讨会之外, AAAI-16 还为学生特别主办了多场活动。其中最为火爆的是招聘会( job fair )和快速约会( speed dating )。在招聘会中,由 AAAI 的主办方请来了多家业内顶尖公司,其中国内的百度,华为和嘀嘀打车也前来参与招聘。 AAAI-16 的参会学生可以自由参与招聘会,听取招聘方的介绍,投递简历及与招聘主管面对面交流。

在快速约会中,参与的学生每四人为一组,在五分钟之内互相介绍自己的研究兴趣。当五分钟到时,铃声会响起,学生轮流依次交换座位,形成新的四人组,向新的伙伴介绍自己的研究兴趣。在为期一个小时的快速约会中,我认识了很多和我有同样研究兴趣的同学,其中既有来自国内高校的也有来自国外高校的。此外,通过和一个做强化学习( reinforcement learning )的同学的交流,我快速地理解了最近兴起的深度强化学习( deep reinforcement learning )和传统的强化学习的区别。由于 AAAI 是一个综合性的会议,在快速约会中我还与不同研究方向的同学进行了交流,比如来自自然语言处理,博弈论等方向的同学,这一类活动的举办对于年轻的参会学生来说是非常有益的。

微软在 AAAI-16

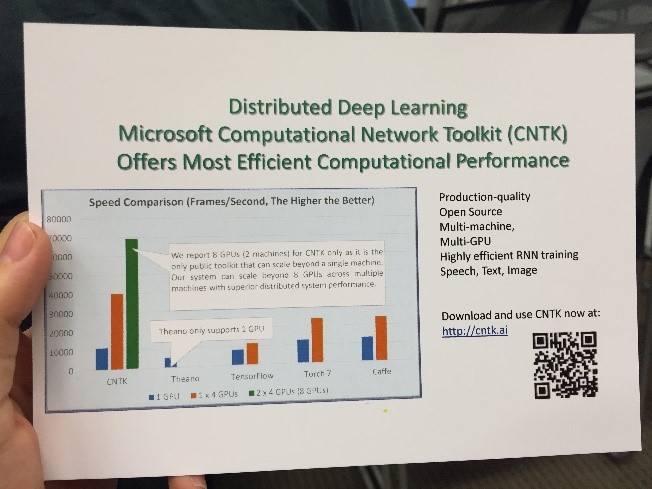

微软在 AAAI-16 在主会场设置了自己的展台。在茶歇时,很多参会者都会到展台观看产品介绍,与工作人员互动和了解招聘情况。此外,微软还向参会者着重推荐了自己的分布式深度学习工具: CNTK 。与其他的深度学习开源框架相比, CNTK 具有效率上的巨大优势。这种效率优势不仅体现在单机单卡的环境下,而且在单机多卡及多机多卡上均有体现。事实上,微软亚洲研究院的机器学习组( Machine Learning Group )目前仍然在致力于用他们推出的 开源分布式机器学习工具 DMTK 来提高 CNTK 在多机多卡时的运行效率,期待 DMTK 和 CNTK 的结合可以为我们带来更高效、更易用的分布式深度学习工具。

微软的分布式深度学习工具

微软的分布式深度学习工具

微软亚洲研究院在 AAAI-16 上发表了多篇论文,可谓收获颇丰。这些论文来自多个方向,比如来自信息检索领域的文章 Improving Recommendation of Tail Tags for Questions in Community Question Answering ,来自机器学习与网络领域的文章 Hashtag-Based Sub-Event Discovery Using Mutually Generative LDA in Twitter 等。

我们团队的论文“ On the Depth of Deep Neural Networks: A theoretical View ”是一篇关于深度学习理论的文章。深度学习在各个应用领域取得的成果不胜枚举,但是在理论方面却相对欠缺。我们的论文将关注点放在神经网络的深度上,从统计学习理论的角度,研究了深度对深度神经网络泛化能力的影响。我们的理论结果定量地描述了:随着深度的增加,神经网络的泛化性能(用 Rademacher Complexity 衡量)变差,但是逼近性能(用 Betti Number 衡量)变好。从而,神经网络存在最优的深度。我们在论文的准备过程中,首先重新回顾了神经网络理论的发展历史。在 90 年代,神经网络曾经风靡一时,涌现出了一大批关于神经网络的理论的文章。由于当时计算机计算能力和数据规模的限制,所用的神经网络大多不是深层的,因此这个时期的理论也没有关注深度问题。 2006 年之后,深度神经网络被重磅推出,然而,对于深度神经网络,很多现象都难以用 90 年代的理论去解释了。这也是我们做这篇文章的初衷。我有幸对我们的工作进行了口头报告。值得高兴的是,我们的工作得到了大家的关注,报告现场挤满了人,报告结束后后举手提问的人也非常多。这个是让我非常意外又惊喜的事情,因为在准备过程中我一直有点担心理论的文章受众范围小并且难以让观众快速理解,从而造成提问环节的冷场,但事实上大家对这个理论问题还是很感兴趣的,也愿意多了解一些。

总的来说,这次参加 AAAI-16 让我收获颇丰。 AAAI 是一个综合性很强的大会,在会议上我接触到了很多新的领域并且认识了不同领域的研究者。此外, AAAI 组织的各种主题讲座和特邀报告请到的都是非常资深的研究人员,从他们身上我不仅学到了新的知识,还学到了很多演讲技巧。会议的整体氛围也很好,无论是在中场休息( coffee break )还是海报环节( poster session ),随处可见讨论的人。

作者介绍

我是孙诗昭,是微软亚洲研究院的一名实习生,现在就读于南开大学,同时也是南开大学 - 微软亚洲研究院联合培养博士项目的一名成员。我的研究兴趣是深度学习理论和并行化机器学习。

微软亚洲研究院的实习经历使我成长许多。在这里,我从优秀的研究员们身上学到了很多。除了学到了如何完成论文之外,我还收获了很多其他技能,比如团队的合作,时间管理,进度控制等。此外,在研究院我还认识了很多非常棒的实习生,他们都可以说是身怀绝技各有所长,与他们一起学习生活给我带来了很多乐趣。

了解微软亚洲研究院实习生项目,欢迎关注“明日之星”实习生项目介绍。更多实习机会请见: http://www.msra.cn/zh-cn/jobs/interns/internopenings.aspx

推荐阅读:

前沿理论、反思创新、产学结合——你不能错过的WSDM 2016大会

【年度学术大会合集】SIGGRAPH,KDD,AAAI,NIPS…这些你想参加的会议

机器学习的盛宴:NIPS 2015

欢迎关注

微软亚洲研究院官方网站:http://www.msra.cn

微软亚洲研究院人人网主页:http://page.renren.com/600674137

微软亚洲研究院微博:http://t.sina.com.cn/msra

微软亚洲研究院微信:搜索“微软研究院“或扫描下方二维码:

![[HBLOG]公众号](http://www.liuhaihua.cn/img/qrcode_gzh.jpg)